AI w redakcji tekstów naukowych

W czasach, w których naukowcy coraz chętniej powierzają AI redakcję i tłumaczenie tekstów naukowych, rodzi się pytanie: czy naprawdę możemy jej w pełni zaufać? Choć kusi obietnicą szybkości, w praktyce wymaga precyzyjnych poleceń, licznych poprawek i żmudnego składania fragmentów w całość. Co więcej, zamiast rozmowy i wspólnego namysłu z drugim człowiekiem, praca z AI staje się samotnym doświadczeniem.

Dlatego warto się zastanowić: czy chcemy pracować w ciszy, sam na sam z algorytmem, czy jednak dzielić się tekstem z drugim człowiekiem, który nie tylko poprawi przecinki, ale przede wszystkim pomoże nam lepiej zrozumieć własny przekaz?

AI w redakcji jako narzędzie – kuszące, ale wymagające

AI wymaga bardzo kompetentnego użytkownika – niezbędna jest przemyślana i precyzyjna komunikacja z narzędziem, pozwalająca uzyskać pożądane efekty. Równocześnie konieczna jest umiejętność krytycznej oceny wygenerowanych wyników, rozpoznawania błędów, niedokładności czy sugestii, które mogą wprowadzać w błąd. W praktyce oznacza to, że praca z tego typu narzędziami wymaga od użytkownika wysokich kompetencji językowych i świadomości ograniczeń AI. Innymi słowy, aby skutecznie korzystać z AI, trzeba samemu być profesjonalnym redaktorem i… poświęcić na to sporo czasu.

Pętla promptów, czyli kiedy „przyspieszenie” zajmuje dłużej

Czy narzędzia AI zawsze przyspieszają pracę? Wszak ich obsługa często przypomina dialog z oczytanym, ale bardzo rozkojarzonym asystentem. Otrzymany wynik trzeba poprawić, potem poprosić o kolejną wersję, porównać, skorygować nowe błędy, znowu sformułować komentarz… i tak dalej. Każda kolejna próba może zbliżać nas do pożądanego efektu – ale równie dobrze może oddalać, jeśli narzędzie nie zrozumie kontekstu lub zgubi wcześniejsze ustalenia. Co gorsza, AI potrafi też z pełnym przekonaniem tworzyć nieistniejące fakty, zmyślać źródła, przeinaczać cytaty czy wymyślać słowa, które brzmią sensownie – ale nie mają żadnego uzasadnienia.

Efekt? Choć AI może wydawać się drogą na skróty, w praktyce bywa źródłem frustracji i kosztownej straty czasu, szczególnie gdy zależy nam na tekście spójnym, klarownym i zgodnym z intencją autora.

AI nie czyta między wierszami

Największa słabość sztucznej inteligencji? Brak rozumienia. Model językowy operuje na poziomie statystyki i formy: analizuje słowa, ich kolejność i częstotliwość. Nie rozumie jednak, dlaczego autor używa danego terminu ani co dokładnie chce przekazać. Zamiast tego proponuje najczęstsze, najbezpieczniejsze rozwiązania – a więc schematy.

Problem polega na tym, że AI nie rozumie tonu, kontekstu, zamysłu. Zwykle nie potrafi zinterpretować ironii, wyczuć niuansu, zidentyfikować ryzyka nieporozumień. Dobry redaktor stara się natomiast zaproponować zmiany, które lepiej eksponują myśl, a nie ją zamazują. I w odróżnieniu od AI prowadzi rzeczywisty dialog z autorem – wyjaśnia mniej oczywiste zmiany i wyraźnie zaznacza miejsca, w których potrzebna jest dodatkowa konsultacja.

AI nie pamięta kontekstu

Choć nowoczesne modele językowe mogą technicznie przetwarzać długie teksty, w praktyce już po kilku stronach zaczynają tracić orientację w szczegółach. Gubią terminologię, przestają podążać za argumentacją, zapominają wcześniejsze założenia. A przecież praca akademicka – a nawet pojedynczy akapit – to nie zbiór luźno powiązanych zdań, lecz logiczna konstrukcja, której spójność jest podstawą wiarygodności. AI może przekształcić jedno zdanie tak, by było stylistycznie poprawne – ale nie zauważy, że wprowadza tym sprzeczność z wcześniejszą tezą albo zniekształca sens kluczowego pojęcia.

AI proponuje schemat zamiast stylu

Sztuczna inteligencja nie tworzy unikalnego stylu – co więcej, aktywnie go niweluje. Narzędzia językowe dążą do średniej: preferują najczęstsze sformułowania, unikają ryzyka, wygładzają to, co nietypowe. Tymczasem styl naukowy to często bardzo precyzyjne użycie niestandardowej terminologii, granie niuansami czy prowadzenie unikalnej narracji.

W dobrej redakcji liczy się nie tylko poprawność, ale i wyczucie – na przykład wtedy, gdy trzeba zdecydować, czy długie zdanie warto zachować, czy rozbić na krótsze. Algorytmy językowe niemal zawsze wybierają to drugie, bo tak są zaprojektowane. Tymczasem w tekście naukowym składnia to także narzędzie argumentacji. Równie istotne są subtelne rozróżnienia: model, czy framework; accuracy, czy precision; interpretation, czy explanation. Wybór często ma charakter nie tylko stylistyczny, lecz także merytoryczny.

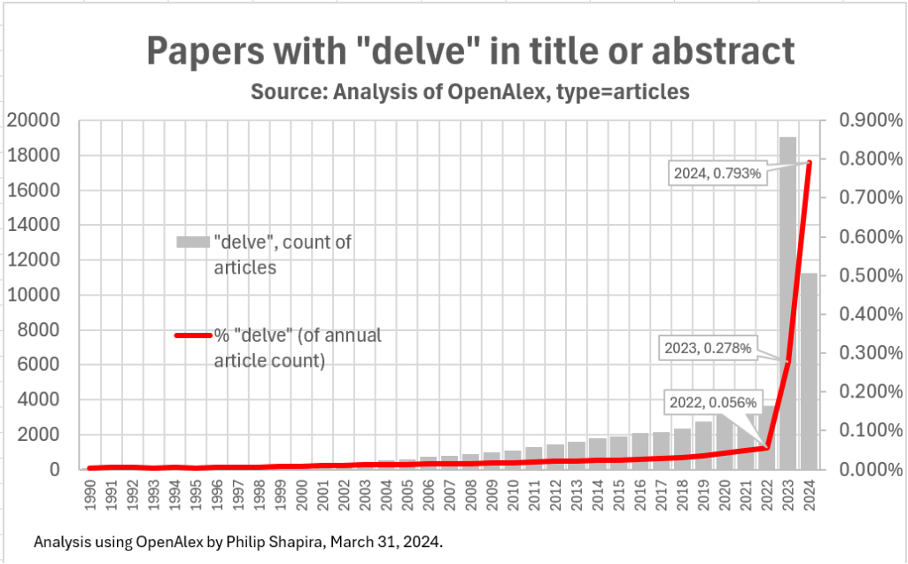

Dobrzy redaktorzy z reguły czuwają też nad tym, by nie ulec modnym, ale pustym frazesom. Słynny już przykład frazy delve into – nadużywanej w tekstach akademickich („this paper delves into the nature of…”) – doskonale pokazuje, jak korzystanie z AI może prowadzić do uniformizacji stylu i utraty autorskiego tonu.

AI nie bierze odpowiedzialności za słowa

Na koniec najważniejsze: sztuczna inteligencja nie odpowiada za swoje sugestie. Jeśli zaproponowane zmiany zniekształcą sens, wprowadzą niezamierzoną dwuznaczność, błędny lub niewłaściwie nacechowany termin, albo – co gorsza – zostaną wykryte przez narzędzia antyplagiatowe bądź detektory AI, pełną odpowiedzialność za ich konsekwencje ponosi wyłącznie autor. Tymczasem redagujący tekst ludzie są sami odpowiedzialni za zmiany, które proponują – ręczą za nie swoją reputacją. W końcu to właśnie zaufanie, które zdobywają wśród autorów, jest fundamentem ich zawodowej wiarygodności. Dlatego redaktorom – w przeciwieństwie do algorytmów – naprawdę zależy na końcowym efekcie.

Podsumowanie: AI nie zastąpi redakcji

AI w redakcji może być użytecznym narzędziem – pomaga uporządkować tekst, poprawia oczywiste błędy, czasem zaproponuje trafniejsze sformułowanie. Jednak nawet najbardziej zaawansowany algorytm nie zastąpi tego, co wnosi żywy człowiek: uważnego czytania, zadawania pytań, wczuwania się w sens i intencje autora.Jak pisał Eric Raymond o pracy nad kodem oprogramowania: „Wystarczająca liczba przyglądających się oczu sprawia, że wszystkie błędy stają się banalne”. Podobnie jest z pracą nad tekstem: lepiej grać zespołowo, korzystając z wielu ludzkich perspektyw – nawet jeśli są ograniczone i subiektywne – niż grać tekstem w ping-ponga ze sztuczną inteligencją, która nie rozumie kontekstu i nie potrafi zadawać pytań. To właśnie wspólna praca i rozmowa pozwalają lepiej dopracować tekst i oddać to, co naprawdę chcemy powiedzieć.

Jan Burzyński

***

Chcesz dowiedzieć się więcej o sztucznej inteligencji w pracy naukowca? Przeczytaj nasz artykuł “Jak generatywne AI wpływa na redakcję tekstów akademickich?”!